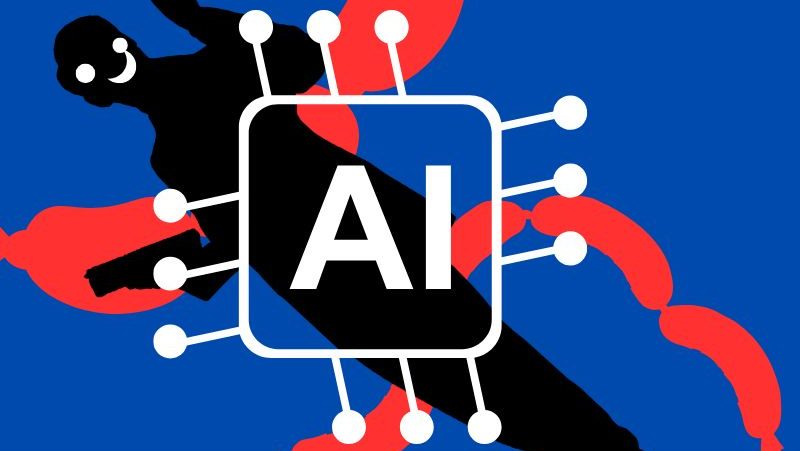

生成AI「Grok」に批判噴出 画像編集機能が児童保護と規制論争を招く

2025年1月2日、米xAIが開発する対話型生成AI「Grok」は、画像編集機能を通じて児童や女性を性的に加工できるとの苦情が相次いだことを受け、不具合の修正に取り組んでいると発表した。

Grokの画像編集機能、児童性的虐待への悪用疑惑が拡大

問題視されているのは、2024年12月下旬に追加されたGrokの「画像編集」機能である。X(旧ツイッター)上の画像を加工できる仕組みだが、被写体の同意なく女性や子どもの服を脱がせ、性的な画像に変換する事例が報告された。

これを受けxAIは、セーフガードに不具合があったことを認め、緊急の修正作業に着手しているとXで説明した。

同社は児童性的虐待コンテンツ(CSAM ※)が違法であり、禁止対象である点を明言している。

米国では、児童ポルノの作成や拡散を故意に助長、または防止しなかった企業が刑事訴追される可能性があるとされる。

さらにインド当局は、同意なきヌードや性的コンテンツ削除に向けた対応をXに求め、フランス検察もGrokが児童ポルノに利用された疑いを捜査対象に追加した。

Grokは過去にも誤情報や過激表現で批判を浴びており、信頼性への疑念が強まっている。

※CSAM(児童性的虐待コンテンツ):児童を対象とした性的画像や動画を指す国際用語。多くの国で制作・所持・配布が重罪とされ、IT企業には検出・防止措置が強く求められている。

利便性とリスクの両立が焦点、生成AI規制は新段階へ

画像編集機能は、クリエイティブ用途や情報発信の効率化という点で大きな利点を持つ。生成AIが誰でも高度な編集を可能にする点は、表現の民主化につながる側面もある。

一方で、今回の事例が示すように、未成年者や第三者の権利侵害が容易に起こり得る点は重大なリスクだ。

特に児童保護は国際的に厳格な基準が存在し、AI提供企業には高度な管理責任が求められる。

今後は、モデル性能の向上だけでなく、機能制限や利用監視、説明責任を含むガバナンス設計が競争力を左右すると考えられる。

各国当局の動向次第では、生成AIの画像編集機能そのものが規制対象となり、業界全体の開発方針に影響を与える可能性もある。

関連記事:

生成AIによる児童のディープフェイク被害が顕在化 警察庁が実例公表し対策強化へ