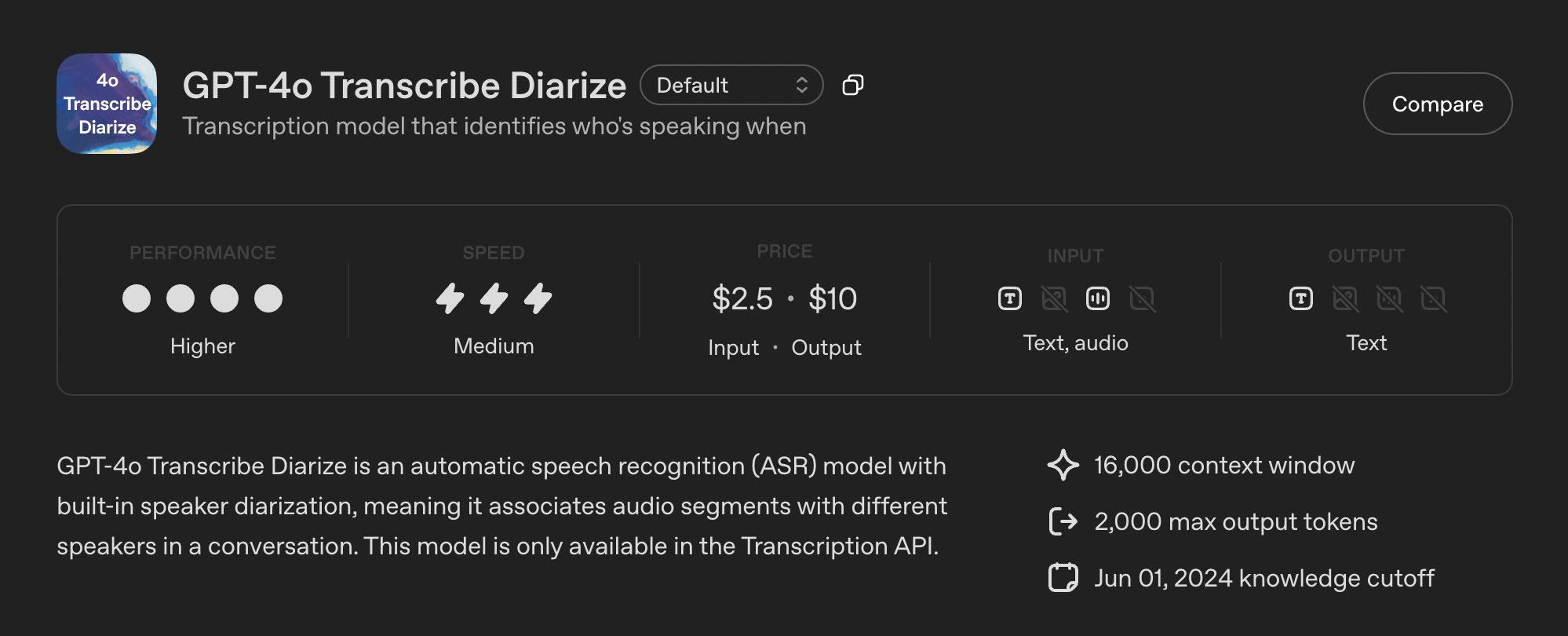

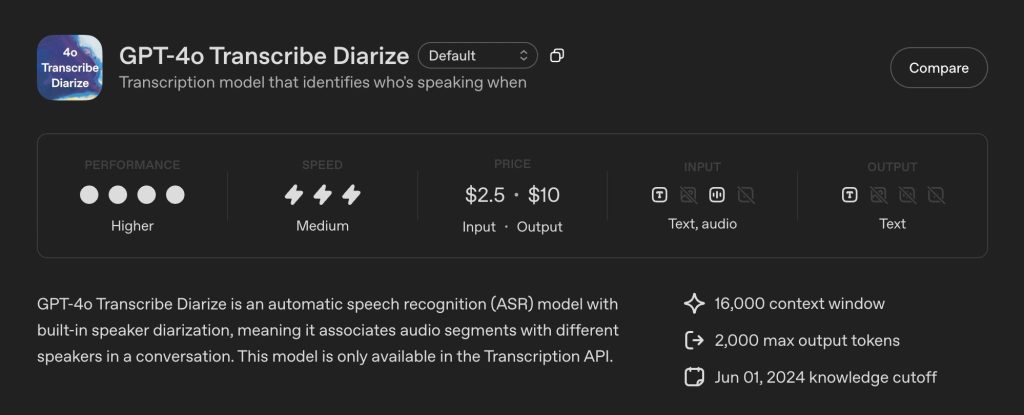

OpenAIが「話者分離」機能の音声認識モデル「GPT-4o Transcribe Diarize」を発表

音声認識技術は、私たちのビジネスや日常生活において急速にその存在感を増しています。しかし、従来の技術では「何を話したか」はわかっても、「誰が話したか」を正確に識別することは大きな課題でした。特に複数の人間が参加する会議やインタビューの記録において、発言者ごとのテキスト化は多くの手間を要求されてきました。 この長年の課題に対し、OpenAIが「GPT-4o Transcribe Diarize」という新たなモデルをAudio APIで発表したことは、音声データ活用のあり方を根本から変える可能性を秘めています。本記事では、この新しい話者分離技術が具体的にどのような機能を提供し、ビジネスにどのような変革をもたらすのかを深掘りするため、本プロジェクトの詳細を考察します。

音声認識の新たな地平を拓く「GPT-4o Transcribe Diarize」

OpenAIが新たに発表した「GPT-4o Transcribe Diarize」は、音声認識技術における積年の課題であった「話者分離(Diarization)」に本格的に対応したモデルとして、大きな注目を集めています。従来の高性能な文字起こしモデル、例えば「Whisper」や初期の「gpt-4o-transcribe」モデルは、音声データから高精度にテキストを抽出することには長けていましたが、複数の話者が混在する音声において、それぞれの発言を個別に識別し、話者ごとにラベリングする機能は搭載されていませんでした。 しかし、今回登場した新モデルは、この話者分離機能を標準で備えています。例えば会議の録音データを処理する際、単に発言内容がテキスト化されるだけでなく、「話者A」「話者B」といった形で、誰がどの部分を発言したのかが明確に区別された形で出力されます。公式な情報によれば、この機能はOpenAIのAudio APIを通じて利用可能となり、開発者はAPIを呼び出すことで、話者ラベルが付与されたタイムスタンプ付きのデータをJSON形式で受け取ることができるようになるとされています。これは、議事録作成の自動化、コールセンターの応対分析、ポッドキャストや動画コンテンツの字幕作成など、音声データを扱うあらゆるシーンでの劇的な効率化を予感させます。

新モデルが提供する具体的な機能と仕組み

「GPT-4o Transcribe Diarize」の登場は、単なる文字起こし精度の向上とは異なり、音声認識の「質」を変えるものです。複数の声が飛び交う実際のコミュニケーション場面で、AIが「誰が」話したかを理解することは、データ活用において決定的な差を生み出します。本項では、この新モデルが提供する具体的な機能と、その背景にあると考えられる仕組みを3つの観点から解説します。

自動的な話者の検出とラベリング

この新モデルの最も中心的な機能は、音声データ内に存在する複数の話者をAIが自動的に検出し、それぞれに一意のラベル(例:「Speaker 1」「Speaker 2」)を割り当てる能力です。従来、この処理を実現するためには、まず高性能な文字起こしモデルで全体のテキストを生成し、その後、別の話者分離専用のAIモデルやツール(例えばPyAnnoteなど)を組み合わせて、発言の区切りと話者を推定する必要がありました。しかし、「GPT-4o Transcribe Diarize」は、この一連のプロセスを単一のAPI呼び出しで完結させることができるとみられています。これにより、開発者は複雑なパイプラインを構築・管理する手間から解放され、より迅速に高精度な話者分離済みテキストデータを取得できることが期待されます。

オプション機能としての「話者参照クリップ」

さらに注目すべきは、オプションとして提供される「話者参照クリップ」機能の存在です。これは、既知の話者がいる場合に、その人物の声を事前にAIに学習させる機能であると推測されます。具体的には、開発者がAPIリクエストの際に、特定の人物(例えば「田中部長」)の短い音声サンプル(公式コミュニティの情報によれば2秒から10秒程度)を「参照クリップ」として提供します。AIはこの音声的特徴を学習し、処理対象の音声ファイル全体からその人物の発言を特定、「田中部長」という具体的なラベル(あるいは開発者が指定したID)で識別することが可能になると考えられます。公式情報では最大4人までの既知の話者に対応できるとされており、主要な参加者が決まっている会議などでは、極めて実用的な機能となるでしょう。

「diarized_json」形式による詳細な出力

このモデルは、単にテキストを返すだけでなく、「diarized_json」という新しいレスポンス形式を提供します。これは、話者分離の結果を構造化データとして詳細に出力するためのものです。このJSONデータには、文字起こしされたテキストのセグメント(発言の断片)ごとに、発言の開始時刻と終了時刻(タイムスタンプ)、そしてその発言を行った話者のラベル(自動検出された「Speaker 1」や、参照クリップで指定された特定のID)が含まれるとされています。このタイムスタンプと話者ラベルが紐付いたデータ構造は、後のデータ分析にとって非常に価値が高いものです。例えば、「特定の顧客がクレームを発言した時間帯」や「会議の後半で話者が交代した頻度」などを即座に分析することが可能になります。

従来技術と比較した導入のメリット

「GPT-4o Transcribe Diarize」がもたらす価値は、単なる新機能の追加にとどまりません。これまで音声認識と話者分離が別々の技術として扱われてきたことによる非効率性や精度の限界を、根本的に解決する可能性を秘めています。ここでは、従来の技術構成と比較した場合の具体的な導入メリットについて、3つの側面から考察します。

単一モデルによる処理の高速化と精度向上

従来のシステムでは、まずWhisperのようなモデルで全体の文字起こしを行い、そのテキストと元の音声を突き合わせながら、別の話者分離モデルが「どこで話者が変わったか」を推定するのが一般的でした。この方式は、二つの異なるモデルが連携するため処理が複雑になり、時間がかかるだけでなく、それぞれのモデルの誤差が累積しやすいという欠点がありました。「GPT-4o Transcribe Diarize」は、OpenAIの強力な基盤モデルであるGPT-4oをベースに、文字起こしと話者分離を同時に(あるいは緊密に連携して)処理するように設計されていると推測されます。処理速度が劇的に向上する(MicrosoftのAzureでの発表によれば、10分の音声を約15秒で処理するとの情報もあります)と同時に、文脈と音声的特徴を一貫して解析できるため、話者の変わり目をより正確に捉えられるようになることが期待されます。

システム開発・運用コストの劇的な削減

開発者の視点から見ると、メリットは非常に大きいと言えます。従来は、高性能な文字起こしAPIと、オープンソースまたは商用の話者分離ライブラリを個別に選定・契約し、それらを連携させるための複雑なシステム(パイプライン)を自前で構築する必要がありました。特に話者分離ライブラリのセットアップやチューニングには専門的な知識が要求されることが多く、開発のハードルとなっていました。新モデルでは、OpenAIのAudio APIという単一のエンドポイントを呼び出すだけで両方の機能が実現できるため、システム設計が大幅に簡素化されます。開発工数が削減されるだけでなく、インフラの維持管理や複数のAPIのバージョンアップ対応といった運用コストも大幅に圧縮できると見込まれます。

リアルタイム処理への応用可能性

この新モデルが、特にMicrosoft Azureのプラットフォームで「リアルタイム知性(Real-Time Intelligence)」の一部として紹介されている点は重要です。これは、この技術が単なる録音ファイルのバッチ処理(一括処理)にとどまらず、リアルタイムのストリーミング音声にも適用される可能性を示唆しています。もしリアルタイムで話者分離が実現できれば、その応用範囲は一気に広がります。例えば、オンライン会議中に「今、誰が話しているか」をリアルタイムで識別し、その場で即座に字幕や議事録に反映させることが可能になります。また、コールセンターにおいても、顧客とオペレーターの発言をリアルタイムで区別しながらテキスト化し、即座に感情分析やFAQの提示を行うといった、より高度なオペレーター支援が実現すると考えられます。

導入にあたって考慮すべき点と潜在的な課題

「GPT-4o Transcribe Diarize」は多くの可能性を秘めていますが、一方で、実際のビジネスシーンに導入する際には、いくつかの考慮すべき点や潜在的な課題も存在すると考えられます。まず、精度の問題です。話者分離技術は、音声が重なっている部分(いわゆる「かぶり発言」)や、声質が非常に似通っている話者が複数いる場合、あるいは極端に短い発言が続く場合に、識別精度が低下する傾向があります。新モデルがこれらの困難なケースにどれほど対処できるかは、実際の利用を通じて検証していく必要があります。特に「話者参照クリップ」機能を使用しない場合、AIが自動で割り当てる話者ラベル(Speaker 1, 2…)が、会話の途中で入れ替わってしまう(例えば、AさんをSpeaker 1と認識していたのに、途中からSpeaker 2としてしまう)可能性もゼロではありません。 また、処理できる話者の人数にも限界があると考えられます。現時点で「話者参照クリップ」は最大4人までとされていますが、参照なしの自動検出の場合に何人までを現実的な精度で分離できるのかは、重要なポイントです。 さらに、プライバシーと倫理的な側面も無視できません。特に「話者参照クリップ」機能は、個人の「声」という生体認証情報に近いデータをAIに学習させることを意味します。この音声データをどのように管理し、本人の同意をいかに得るか、また、学習させた音声データが他の目的に流用されないかといった点について、厳格なガイドラインと運用ルールの策定が不可欠です。声の特徴を悪用したなりすましなどのリスクも考慮し、技術的な安全策と法的な枠組みの両面から、慎重な検討が求められるでしょう。

今後の展望

OpenAIによる話者分離機能の提供は、音声認識技術が「記録」のツールから、「理解」のツールへと進化する大きな一歩を示しています。AIが単に言葉を聞き取るだけでなく、「誰が、いつ、何を」話したかを文脈とセットで把握し始めることは、ビジネスプロセスの自動化やデータ活用のあり方を根本から変える可能性を秘めています。AIが真に会議の参加者や対話の当事者として機能するためには、この話者識別能力が不可欠な基盤技術となります。

会議・商談の「完全なるデジタルツイン」化の実現

「GPT-4o Transcribe Diarize」の登場により、会議や商談の内容を、発言者情報を含めて完全にデジタルデータ化する「デジタルツイン」の実現が大きく前進すると考えられます。従来の議事録は、発言内容の要約が中心であり、誰がどのようなニュアンスで発言したかの情報は失われがちでした。しかし、新モデルを活用すれば、タイムスタンプと話者ラベル付きの完全な文字起こしデータが自動生成されます。 このデータは、単なる記録以上の価値を持ちます。例えば、このテキストデータを大規模言語モデル(LLM)に入力することで、「会議の決定事項」「各参加者の主要な意見」「AさんとBさんの意見が対立したポイント」「次のアクションアイテムとその担当者」などを、話者情報に基づいて正確に抽出・要約させることが可能になります。さらに、このデータをCRM(顧客関係管理)システムと連携させれば、商談履歴として「顧客の誰がどのような懸念を示し、自社の誰がどう回答したか」を詳細に記録・分析できます。営業担当者間の情報共有の質が劇的に向上し、顧客対応の精度向上や、過去の商談データに基づく効果的な営業戦略の立案にも貢献すると期待されます。

コールセンターにおける顧客体験(CX)の革新的向上

コールセンターは、この新技術によって最も大きな変革を遂げる分野の一つと予測されます。従来の音声認識では、顧客とオペレーターの会話が混在した一つのテキストとして出力されるため、その後の分析が困難でした。しかし、話者分離が正確に行えれば、「顧客の発言」と「オペレーターの発言」を明確に区別してテキスト化できます。 まず「顧客の発言」のみを対象とした高精度な感情分析やキーワード抽出が可能になります。顧客がどの時点で不満を感じたか、どのキーワードに最も強く反応したかを正確に把握できるため、応対品質の客観的な評価や、顧客インサイトの抽出が飛躍的に進みます。一方、「オペレーターの発言」を分析することで、コンプライアンス違反(不適切な発言)の自動検出や、逆に優れた応対(アップセルにつながったトーク)のパターンを発見し、オペレーター教育の教材として活用できます。将来的には、AIがリアルタイムで両者の発言を識別し、顧客が難しい質問をした瞬間にオペレーターの画面に関連するFAQを提示したり、オペレーターが禁止用語を使いそうになったらアラートを出すといった、高度なリアルタイム支援システムの構築も現実味を帯びてきます。

音声インターフェースの「パーソナライズ化」と進化

AIスピーカーや音声アシスタントといった既存の音声インターフェースも、話者分離技術によって大きく進化すると考えられます。現状の多くのデバイスは、基本的に「誰が話しかけても」同じように応答します。しかし、「GPT-4o Transcribe Diarize」のような技術、特に「話者参照クリップ」機能が応用されれば、デバイスが家族のメンバー(父、母、子供)を声で識別することが可能になります。 例えば、父親が「今日の予定は?」と尋ねれば父親の仕事のスケジュールを答え、子供が「今日の予定は?」と尋ねれば学校の時間割や習い事の予定を答えるといった、高度なパーソナライズが実現します。また、家庭内の複数の人間が同時にAIと対話するような、より自然なコミュニケーションも可能になるでしょう。ビジネス用途においても、共有スペースに設置されたAIアシスタントが、会議室に入室した社員(A部長、B課長)の声を識別し、「A部長、14時からの定例会議の資料はこちらです」「B課長、〇〇さんから折り返し依頼が来ています」といった形で、個人に最適化された情報を提供できるようになると期待されます。これは、AIが不特定多数の「ユーザー」ではなく、「あなた」個人を認識して対話する、真のパーソナルアシスタントへと進化する第一歩となるでしょう。