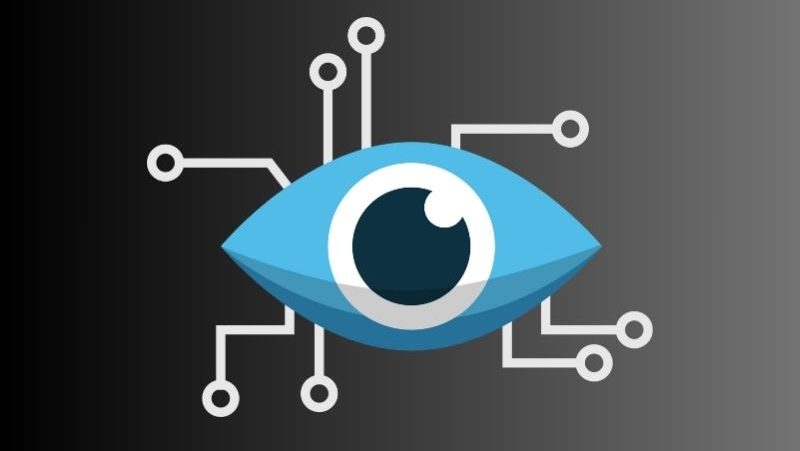

NRIセキュア、AI Yellow Team提供 AIエージェントの設計リスクを可視化

2025年7月29日、NRIセキュアテクノロジーズはAIエージェントの潜在脅威を設計段階で分析し、対策を支援するサービス「AI Yellow Team」の提供を開始した。開発前からセキュリティ対策強化を後押しする、国内初の本格的な取り組みとなる。

設計段階からAIの脅威を洗い出す新サービス始動

NRIセキュアテクノロジーズは、AIエージェントシステムにおける設計時のセキュリティリスクを可視化し、適切な対策を提案する新サービス「AI Yellow Team」を提供開始した。

「AI Yellow Team」は、同社が培ってきた脆弱性診断の知見や国際的なガイドライン、最新の脅威情報を基に、AIエージェント導入初期からのリスク管理を支援するものだ。

近年、AIエージェントの活用が急速に進み、複数のAI同士や外部ツールとの連携が一般化している現状がある。一方で、AIエージェントが本来の目的を逸脱したり、権限を悪用されたりなど、これまでにない脅威も顕在化している。

「AI Yellow Team」は、こうした現状に対抗するためのサービスだ。

開発者や設計担当者へのヒアリング、システム構成の可視化、脅威分析、そして対策の提案という4段階のプロセスを通じて、システム全体のリスクを総合的に評価し、セキュリティ設計の妥当性を確認した上で、必要な措置を事前に提示する。

同社はこれまでにも、リリース前のセキュリティ検証を担う「AI Red Team」、運用後の監視を行う「AI Blue Team」を提供してきた。

今回の「Yellow Team」の登場により、AI開発の全工程をカバーする体制が整った格好になっている。

リスク先取りで設計精度向上へ 開発現場の意識改革にも期待

AI Yellow Teamは、リスクの“事後対応”から“事前回避”へのパラダイムシフトを促すサービスとして注目できる。

従来のAI開発現場では、実装後のテストや運用フェーズで脆弱性が発覚し、対応に時間とコストがかかるケースも多かった。しかし、AI Yellow Teamの登場により、その流れに一石を投じることとなるかもしれない。

また、国際標準や最新の攻撃シナリオを踏まえた対策案が提示されることにより、設計者のセキュリティ意識の底上げにもつながると考えられる。

今後は、金融・行政・医療といったAI活用が進む業界での導入が進む可能性があり、セキュアなAI開発の“標準工程”としての位置づけが期待される。

※脅威モデリング:システム設計時に想定される攻撃経路や脆弱性を洗い出し、セキュリティ対策の必要性と優先度を明確化する手法。近年はAIやクラウド領域でも活用が進んでいる。