オープンウェイト時代の到来、gpt-oss-120b/20bが示す未来

2025年8月5日、OpenAIは2つの革新的なオープンウェイト言語モデル「gpt-oss-120b」と「gpt-oss-20b」を発表しました。これらのモデルは、Apache 2.0ライセンスのもとで提供されており、誰でも自由に利用・改変が可能です。従来のAPIモデルと異なり、インターネット接続が不要なローカル運用も可能な点が注目されており、企業や研究機関を中心に高い関心を集めています。特に、軽量モデルでありながら高精度な推論性能と柔軟なカスタマイズ性を両立している点が評価されているため、本プロジェクトの詳細を考察します。

実用性能を備えた最新のオープンウェイト言語モデルが登場

OpenAIよりgpt-oss-120b および gpt-oss-20b という2つの先進的なオープンウェイト言語モデルが公開されました。

オープンウェイト言語モデルとは、学習済みの重み(パラメータ)が公開されているAIモデルのことです。誰でも自由に利用・改良できるのが特徴で、コストを抑えつつ独自の環境やニーズに応じたカスタマイズが可能です。研究や開発の透明性向上にも貢献します。

これらのモデルは Apache 2.0 ライセンス*のもとで提供されており、誰でも利用が可能です。注目すべきは、同規模の他のオープンモデルと比較して推論性能が優れている点と、ツール活用能力に長けている点です。さらに、一般的なハードウェアでも効率的に稼働するよう最適化されているため、実用性の高さが際立っています。

これらのモデルの学習には、OpenAIの強化学習手法や最先端のフロンティアモデル(o3など)を活用した高度なアプローチが用いられており、その成果が性能にも反映されています。

*Apache 2.0ライセンス:商用利用や改変、再配布が自由にできるオープンソースライセンスです。特許権の明示的許諾も含まれ、安心して利用できます。

2種類のモデルがそれぞれのニーズに対応

gpt-oss-120b は、80GBのGPUを1基使用するだけで動作し、OpenAIの o4-mini に匹敵するレベルの推論精度を示しています。一方の gpt-oss-20b は、わずか16GBのメモリを備えたエッジデバイスでも利用可能で、OpenAIの o3-mini と同等の性能を記録しています。この軽量モデルは、ローカル環境での高速推論やコスト制限のあるプロジェクトに最適であり、柔軟性のある運用を可能にしています。

多様な推論タスクやツール活用に対応

両モデルは、推論タスクやツール使用において非常に高い性能を示しています。特に、few-shot関数呼び出しやチェーン・オブ・ソート(Chain of Thought)による思考プロセスを活用した複雑な推論にも対応しています。HealthBenchでは、OpenAIの独自モデル(GPT-4oやo1)を上回る結果を出しています。

さらに、Responses APIとの互換性も確保されており、指示への適切な応答やWeb検索、Pythonコードの実行といったツール操作も可能です。これにより、より自律的なワークフローへの組み込みがしやすくなっています。また、Structured Output形式の出力にも対応しており、用途に応じた柔軟な応用が期待されます。

高い安全性基準と外部評価による信頼性

安全性は、これらのオープンモデルを公開するにあたり、最も重視された要素の一つです。包括的な安全性トレーニングと評価体制に加えて、gpt-oss-120b には敵対的ファインチューニングを施したバージョンも用意されており、Preparedness Framework に基づいた検証も行われています。

社内で実施された安全性評価においては、フロンティアモデルと同等の水準を維持しており、最新のプロプライエタリモデルと同様の安全基準を開発者に提供しています。研究結果やモデルカードはすでに公開されており、第三者機関による評価も受けています。オープンモデルにおける新たな安全性基準の構築に寄与しています。

APIとオープンウェイトモデルの違い

APIとオープンウェイトモデルの最大の違いは、「どこでモデルを動かすか」にあります。

APIは、外部の提供元(例:OpenAI)のサーバーにアクセスしてAIを利用する仕組みで、常にインターネット接続が必要です。一方、オープンウェイトモデルは学習済みの重みが公開されており、自社のサーバーやローカル環境にインストールして運用できます。そのため、ネットワークが不要で機密情報も社外に出さずに済みます。APIは簡単に導入でき、常に最新のモデルを利用できる反面、外部依存と通信コストが発生します。一方、オープンウェイトは初期構築や管理の負担はありますが、柔軟なカスタマイズと高いセキュリティ性がメリットです。用途やニーズに応じて使い分けるのが理想です。

gpt-oss-120b hugging face:https://huggingface.co/openai/gpt-oss-120b

実用性を重視した学習方法とモデル設計

gpt-ossモデルは、オンプレミス等の環境で使いやすくすることを目的に開発されました。さまざまなシステムやハードウェアで効率よく動かせるように、開発元の高度な事前学習と事後学習の技術を組み合わせて作られています。

これまでにもWhisperやCLIPなどのモデルが公開されていますが、gpt-ossは、GPT-2以降で初めて登場した「オープンウェイト型」の言語モデルとして注目を集めています。

必要な計算だけを行う構造

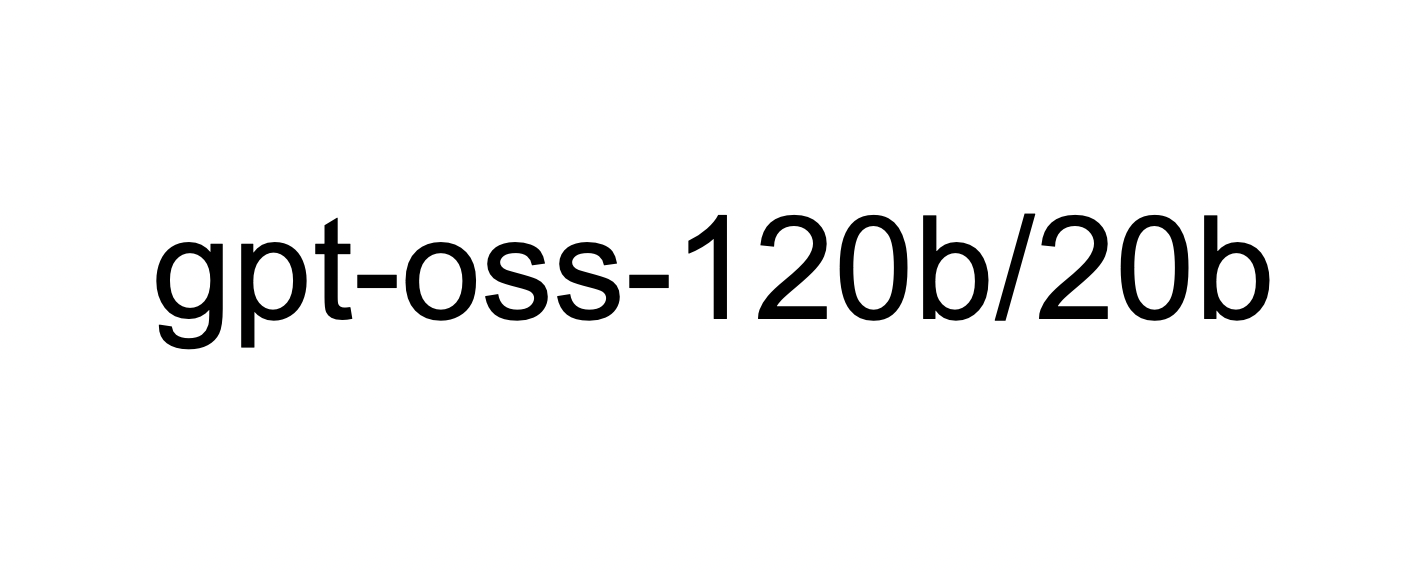

このモデルは「Mixture-of-Experts(MoE)」という仕組みを使っており、入力された内容に合わせて必要なパラメータ(モデル内の情報)だけを選んで使うことで、計算を効率化しています。gpt-oss-120bは1つのトークン(単語など)に対して約51億、gpt-oss-20bは約36億のパラメータを動かしています。全体のパラメータ数はそれぞれ1170億、210億に上ります。

また、GPT-3にも使われているアテンション(情報の関連性を見る処理)の仕組みを改良し、処理の精度とスピードのバランスを取っています。

メモリ節約と大規模対応を両立

モデルは、マルチクエリアテンションと呼ばれる処理方法で、メモリの使用量を減らしながら高い性能を出せるようになっています。さらに、RoPE(回転位置埋め込み)という手法により、非常に長い文章でも自然に処理できるように設計されており、最大で128,000トークンまで対応しています。

このようにgpt-ossは、高性能でありながら使いやすさと効率性を両立した、次世代のAIモデルとなっています。

回答精度を高めるための高度な事後学習プロセス

gpt-ossモデルは、o4-miniに採用されたプロセスと同様の高度な手法を取り入れて事後学習されています。この学習段階には、教師ありファインチューニングと、計算負荷の高い強化学習(RL)ステージが含まれています。モデルはOpenAIの「Model Spec」に準拠するよう調整され、質問に答える際にツールの活用やCoT(Chain of Thought)推論を適切に使いこなすように設計されています。

最先端の推論技術で高い応答品質を実現

このモデルには、OpenAIの社内モデルで使われている最先端の推論技術(SoTAリーズニングモデル)と同様のアプローチが導入されています。その結果、学習後のモデルは複雑な問いにも高い精度で対応できる能力を備えています。

さらに、gpt-oss-120bおよびgpt-oss-20bの両モデルは、OpenAIのoシリーズに見られるような推論レベルの調整機能にも対応しています。推論レベルは「低」「中」「高」の3段階が用意されており、処理速度(レイテンシ)と応答の精度(パフォーマンス)のバランスを用途に応じて選べます。

開発者はこの推論レベルを、システムメッセージ内の短い指示文だけで簡単に指定できるため、柔軟かつ効率的にAIの応答品質をコントロールできるようになっています。

多方面で性能を証明したgpt-ossモデルの評価結果

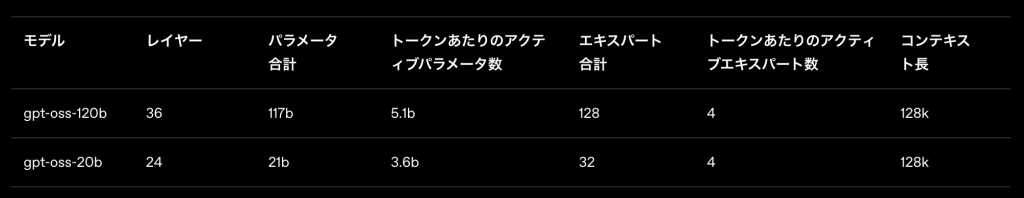

gpt-oss-120bおよびgpt-oss-20bの2モデルは、複数の標準的な学術ベンチマークを用いて性能評価が行われました。評価の対象となったのは、コーディングや数学、医療、そして自律的なツール操作といった実用性の高い分野です。比較対象には、OpenAIが提供する推論モデル群(o3、o3-mini、o4-mini)が選ばれ、それぞれの分野でのモデル性能が明らかになりました。

上位モデルのgpt-oss-120bが見せた圧倒的な実力

gpt-oss-120bは、特に高度なコーディングスキルが求められる競技プログラミング(Codeforces)において、OpenAIのo3-miniを明確に上回る結果を示しました。加えて、一般的な問題解決能力を測るMMLUやHLE、ツール活用スキルを評価するTauBenchといった指標でも、非常に高いスコアを記録しています。

また、医療関連の質問応答を扱うHealthBenchや、難易度の高い数学問題に挑むAIME(2024・2025)でも、gpt-oss-120bはo4-miniを凌ぐ性能を発揮し、その総合力の高さを証明しました。

小型モデルgpt-oss-20bも競争力を発揮

一方で、より軽量なgpt-oss-20bも注目に値します。モデルの規模こそ小さいものの、各ベンチマークにおいてOpenAIのo3-miniに匹敵する成果を上げており、特に競技数学や医療の分野ではそれ以上の結果を残しています。このことから、リソース制約のある環境でも優れた推論性能を実現できることがうかがえます。

今後の考察

gpt-ossシリーズは、ローカルでのAI運用を可能にするだけでなく、教育や研究、そして地域社会における技術活用の可能性を大きく広げています。これらの特徴を通じて、今後どのようなAIの活用が進展するのか、以下に考察します。

ローカルAIによるセキュアな企業運用の加速

オープンウェイトモデルの最大の利点は、ネットワークに依存せずローカル環境で運用できる点にあります。特にgpt-oss-20bのような軽量モデルは、オンプレミスでの導入が容易で、機密性の高い業界──例えば医療、金融、防衛といった分野での活用が進むと考えられます。従来のAPI型AIはクラウド接続が前提であり、セキュリティポリシーの厳しい企業では導入の障壁となっていました。gpt-ossの登場により、外部通信を遮断した状態でもAIが活用できる環境が整い、情報漏洩リスクを最小限に抑える構成が可能になります。

さらに、独自のセキュリティ基準に準拠したファインチューニングや、社内特化の学習も実現しやすくなります。AIを業務プロセスに組み込むだけでなく、継続的な改善と最適化も期待できます。今後はgpt-ossモデルを前提としたオンプレミス型AI製品の開発や、各業界向けのカスタムパッケージが増えると予想されます。

AI開発のボトムアップ化と地域主導型テクノロジーの台頭

オープンウェイトモデルは、大手IT企業によるトップダウンの技術提供だけでなく、地域や個人主導のボトムアップ型のAI開発を後押しする存在にもなり得ます。gpt-ossのようなモデルが無償で提供されることで、スタートアップや地方自治体、教育機関、小規模企業といった従来はAI開発のリソースに潤沢ではない層でも、高品質なAIを自前で育て、導入することが現実味を帯びてきます。

地域特有の言語や文化、商習慣に対応したローカルモデルの構築も可能となり、デジタル地域振興の切り札として期待が高まります。たとえば、方言への対応、地域限定の業務知識の組み込み、小規模商店向けのカスタムAIなど、多様な応用が広がるでしょう。このような地域主導型のAI活用は、グローバル化に逆行するのではなく、より持続可能で分散的な技術エコシステムの形成に寄与する動きとして注目されます。