Apple、「推論モデルの限界」を指摘 複雑な問題では精度が崩壊と論文で分析

2025年6月8日、米AppleのAI研究チームは、大規模推論モデル(LRM)の性能限界に関する論文を公開した。

最新のLRMでも問題の複雑さが一定以上になると推論精度が著しく低下し、論理的推論が困難になる可能性があると指摘している。

AppleがLRMの精度限界を初めて体系的に分析

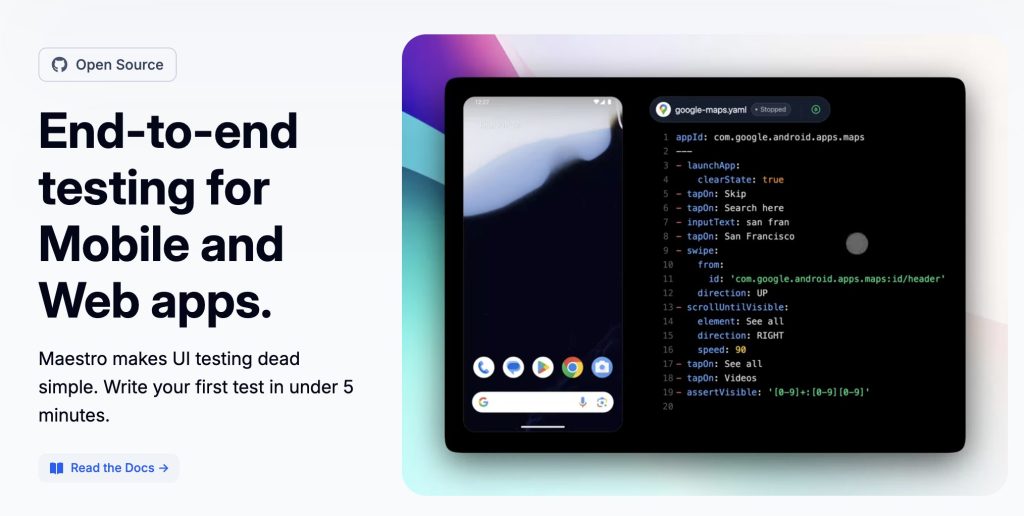

Appleが発表した論文「The Illusion of Thinking:Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity」が、LLM(大規模言語モデル)やLRM(大規模推論モデル)における論理的推論能力の本質に迫る内容となっている。

研究チームは、従来の数学ベンチマーク(※)では測定困難だった推論の限界を明らかにするため、問題の複雑さを段階的に制御できるパズル環境を用いて検証を行った。

対象となったモデルは、OpenAIのo3-mini(medium/high構成)、DeepSeek-R1、DeepSeek-R1-Qwen-32B、AnthropicのClaude 3.7 Sonnet Thinkingなどである。

これらの最先端LRMを用いて、複雑さに応じたパフォーマンスを観察したところ、ある閾値を超えると精度が急激に崩壊することが明らかとなった。

加えて、推論に必要な推論努力(思考トークン量)は問題の難易度と連動して増加するものの、一定の水準を超えると逆に減少に転じる傾向も確認された。

これは、モデルが自律的に困難な問題を解く能力を持たないことを示す兆候といえる。

※数学ベンチマーク:GSM8Kなど、言語モデルの数学的推論能力を評価するための標準化された問題集。

一般化された推論は不可能か Appleが示す技術的限界

Appleの研究は、現行のLRMが直面する根本的な課題を浮き彫りにしている。

モデルが生成する中間推論のトレース(思考プロセス)を解析すると、問題の複雑さに応じて誤答や思考の放棄といった非効率な行動が顕著となった。

たとえば、単純な課題では「考えすぎ」により正答後も探索が続き、中程度の難易度では誤った解法に迷走する傾向が確認された。

そして、複雑性が高いケースでは、正答に一切到達できず、論理的推論が完全に崩れるという結果に至った。

これらの知見を踏まえ、Appleの研究チームは「現在のアプローチでは一般化可能な推論に対する根本的な障壁に直面する可能性がある」と結論付けた。

AIが人間のように汎用的な思考を獲得するには、既存とは異なる設計思想やアプローチが必要である可能性が高いようだ。

Appleは昨年にも「LLMには真の推論が困難」とする論文を発表しており、今回の研究はその延長線上にあるものだと思われる。AIの進化が著しい一方で、論理的思考の実現には依然として高い壁が立ちはだかっているといえよう。

今後のLLM・LRMの次世代モデル開発においては、設計思想そのものから再考する必要があるのかもしれない。