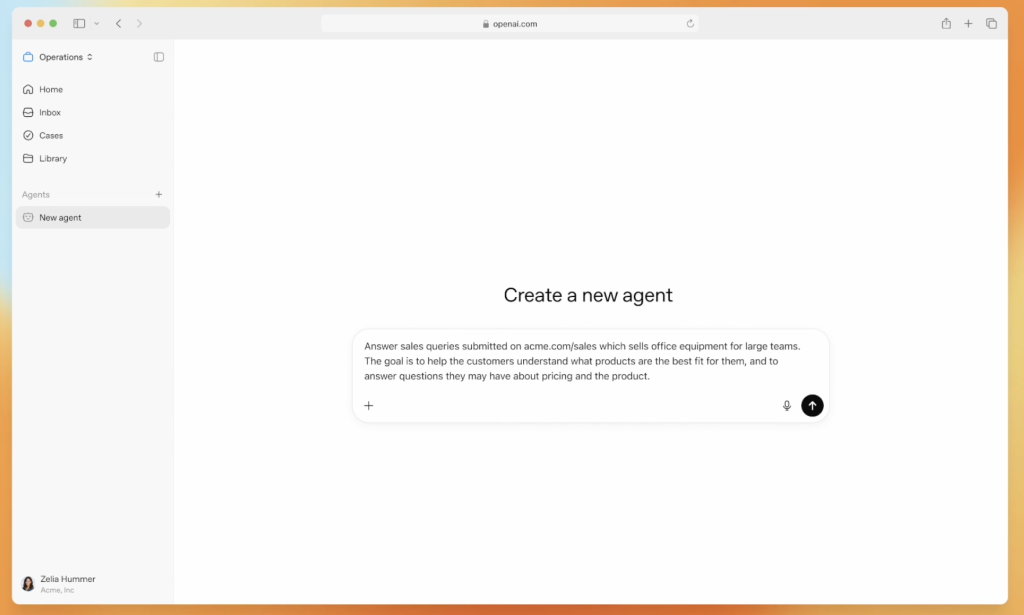

日本語特化の新VLM「Sarashina2-Vision」公開 商用利用も可能に

2025年3月17日、ソフトバンクの子会社であるSB Intuitionsが、日本語に特化した大規模視覚言語モデル(VLM)「Sarashina2-Vision」を発表した。本モデルは、同社の大規模言語モデル(LLM)「Sarashina2」シリーズを基に構築され、MITライセンスのもとで商用利用が可能である。日本のコンテキストに最適化された本モデルの登場は、AI市場に大きな影響を与えることになるだろう。

日本語に特化したVLMの特徴

SB Intuitionsは、日本市場向けのAI技術開発を推進しており、同社の「Sarashina2」シリーズは日本語処理に優れたLLMとして知られている。「Sarashina2-Vision」は、その技術基盤を継承しながら、視覚情報の処理能力を大幅に強化したモデルである。

このモデルは、80億パラメータの8Bモデルと140億パラメータの14Bモデルの2種類が提供され、用途に応じた選択が可能だ。

特に、日本語や日本の文化・慣習に最適化されており、日本に関連する画像の理解能力に優れている。

さらに、複数の日本語ベンチマークにおいて国内最高水準の性能を達成し、日本のコンテキストを深く理解できる点が強みとなる。

VLM(大規模視覚言語モデル ※)は、画像とテキストを組み合わせたマルチモーダルAIであり、画像に関する質問に対して適切な回答を生成する。例えば、東京タワーの写真を提示し、その特徴を尋ねると、建築の詳細や歴史的背景を含めた正確な情報を提供できる。

従来の日本語対応AIモデルに比べ、より高度な視覚理解が可能になっている点が画期的だ。

※VLM(大規模視覚言語モデル):画像とテキストの両方を入力データとし、それらを統合的に理解・解析するAIモデル。従来のテキストベースのAIに比べ、視覚的な情報処理が可能な点が特徴。

データセットの課題と解決策

日本語に特化したVLMの開発において、大きな課題となるのがデータセットの確保である。英語圏では視覚と言語を組み合わせた大規模なデータセットが豊富に存在するが、日本語では質・量ともに不足している。

この問題を解決するため、SB Intuitionsは合成データセットを活用する手法を採用した。

合成データセットとは、既存のデータを基にAIが自動生成したデータを指し、大量の高品質な日本語対応データを効率的に作成することができる。

この手法により、日本語のコンテキストに適した画像と言語データの組み合わせを蓄積し、高精度なモデルの構築が可能となった。

また、MITライセンスのもとで提供されるため、企業や開発者は商用利用を前提とした活用ができる点も注目に値する。

今後、Sarashina2-Visionの活用範囲は広がると考えられる。

広告やEコマースにおける画像解析、観光分野での多言語案内の高度化、教育分野での視覚的な学習支援など、多様な分野での応用が期待される。

日本語に特化したVLMの登場は、日本市場におけるAI技術の新たな発展を促すものとなるだろう。